【データ復旧】

データ復旧サービス 統計処理による最適化

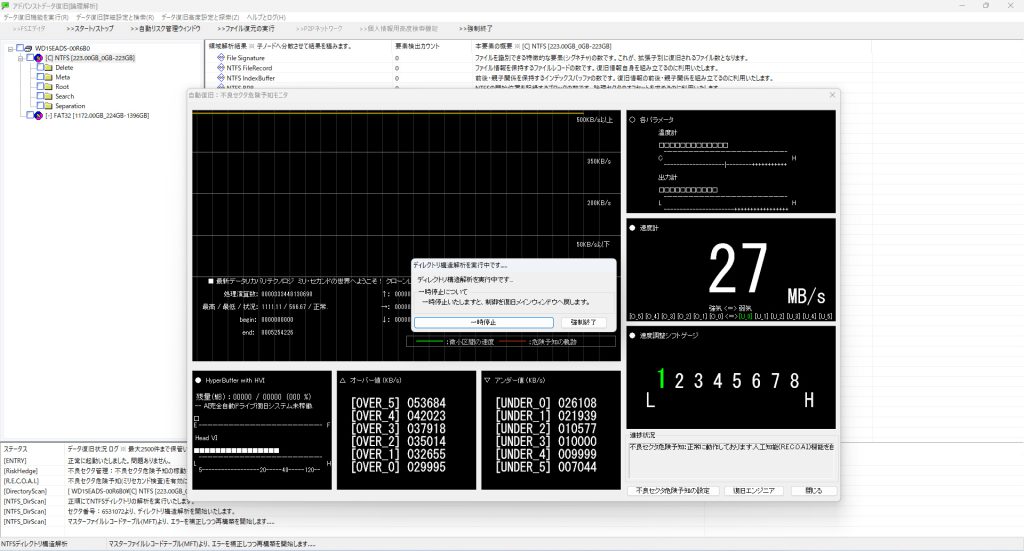

統計処理の導入

先を読むのに使われる手法として統計がございます。例えばコインを投げて表または裏になるかです。歪みのないコインなら表または裏の確率は半々ゆえに投げ続けるとその確率は半々に向かっていくのが感覚的にもわかります。

手数について

データ復旧の解析では「手数」の考え方がとても大切な要素となっております。例えば同じデータを取得する場合であっても複数の方法が存在するものとします。この場合は正常なドライブならば「どちらでもいい(ファイルシステムが成立)」となります。しかしデータ復旧の現場では「手数」が少ない方を優先的に選ぶ必要があります。

ここで「優先的」としたのは「手数」が少ない手法であってもリスクが高い場合にはあえて「手数」が多い方を選択する場合があるためです。

固定化される不良セクタ

不良セクタが発生した場合であっても一度発生した不良セクタが「固定化」されるなら不良セクタの回避方法については、それらをスキャン区間に設定しその区間内を同じルールに固定化して不良セクタを避けることを実現いたします。

不良セクタの対処方法

不良セクタが「200」「1200」「34561」で発生している場合を考えてみます。固定化されている場合、基本的にこれらのセクタの位置が「どこに存在するのか」を判断いたします。

次にファイルシステムを確認いたします。そしてこれらが「MFT」と呼ばれる「マスターファイルテーブル」に多く発生している点をつきとめます。そこでこの「マスターファイルテーブル」の位置は「BPB」と呼ばれるセクタから「一手」で判明できますからそこを「区間」に設定してこのような不良セクタが存在するとみるスキャン方法で「MFT」全区間をスキャンします。ところで「MFT」の必要性です。

MFTには「ファイル名」「ファイルまでの位置」「実ファイルの断片化性」が含まれ「必須(重要)」です。そのため「避ける」という選択肢はありません。あらゆる技術を駆使して、必ずスキャンする場所となっております。

逆にその不良セクタが「インデックスバッファ」だった場合です。この「インデックスバッファ」はファイルシステムへのアクセスの手数を減らすためのインデックスです。これにより「ランダムアクセスが実現」できているのですがデータ復旧では優先度は低いためここに不良セクタが一つでも存在する場合は「避ける」仕組みです。

必要なセクタ・そうではないセクタ。それらを区別してスキャンする方法となっております。